Operations as a Service

La tua infrastruttura, con una marcia in più

AFFIDABILITÀ

Il tuo servizio sempre disponibile

PERFORMANCE

Pronti a scalare

FLESSIBILITÀ

Il cliente prima di tutto

Operations as a Service

La tua infrastruttura, con una marcia in più

Affidabilità

Il tuo servizio sempre disponibile

Performance

Pronti a scalare

Flessibilità

Il cliente prima di tutto

La nostra storia

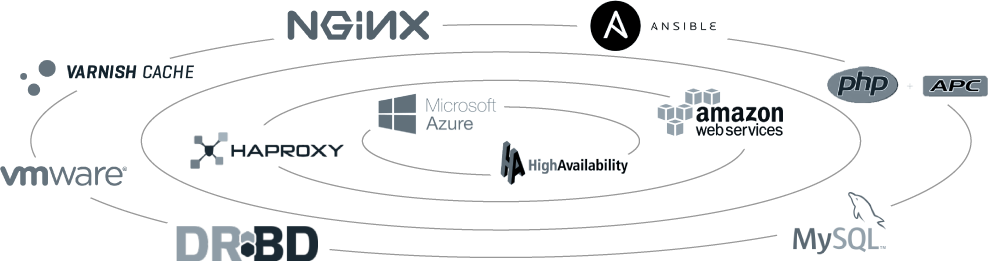

Stardata nasce nel 2003 come azienda specializzata in software open-source per database e clustering. Nel corso degli anni per servire al meglio i nostri clienti abbiamo acquisito competenze avanzate nei principali componenti open-source e non, per costruire servizi web affidabili e scalabili.

Le tecnologie

I nostri valori

Affidabilità

Il successo della tua azienda è legato a doppio filo al mantenimento di SLA elevati sui servizi informatici che la supportano.

Lavorando fianco a fianco con i team di realtà medio-grandi, i nostri architect hanno acquisito l’esperienza per creare design il più possibile failproof e il nostro operation team ha maturato il know-how per risolvere rapidamente le criticità.

.

Performance

La tua infrastruttura informatica ha bisogno di più risorse o deve solo utilizzare più efficientemente quelle di cui dispone?

Stai misurando correttamente l’efficienza dei tuoi servizi?

Stardata ha progettato e gestito l’infrastruttura di portali da >1M di contatti al giorno e dispone dell’esperienza necessaria per garantirti un utilizzo ottimale delle tue risorse con un intervento mirato.

Flessibilità

Il nostro valore aggiunto é l’abilità nel comprendere i requisiti del cliente e nel creare soluzioni affidabili in tempi rapidi.

La nostra missione è offrire un servizio personalizzato e di altissima qualità a tutti i nostri clienti.

Chi siamo

La passione per il software open-source ci accomuna e l’interesse per le reti domina le nostre vite.

Da piu di 20 anni ci occupiamo di amministrazione di macchine Linux su tutto il territorio italiano.

Patrizio Tassone

Founder

Gilberto Ficara

Lead Engineer

Luca Gibelli

Co-founderDicono di noi

Hai una domanda?

Hai bisogno di integrare le tue competenze in-house?

La tua infrastruttura cresce troppo rapidamente e hai bisogno di un supporto esterno per gestirla o migrarla?

Hai problemi di affidabilità o scalabilità?